Bias, zu Deutsch Verzerrung oder Vorurteil. Wenn ein Algorithmus oder eine KI verzerrt arbeitet, bedeutet das: Er behandelt bestimmte Gruppen systematisch unfair, auch wenn das nicht so beabsichtigt war.

Algorithmischer Bias entsteht, wenn ein Algorithmus aufgrund von fehlerhaften Daten oder unausgewogener Programmierung falsche Muster lernt. Die Ursachen dafür sind vielfältig: Die Trainingsdaten spiegeln die Realität nicht richtig wider, beispielsweise wenn mehr Daten über Männer als über Frauen vorhanden sind. Auch kann alte Diskriminierung, die bereits in den historischen Daten steckt (z. B. in früheren Einstellungsentscheidungen), von der KI übernommen und fortgesetzt werden. Zudem können technische Entscheidungen, wie die Gewichtung bestimmter Merkmale, eine Rolle spielen. Ein Beispiel dafür ist ein Kredit-Algorithmus, der Menschen aus ärmeren Stadtteilen automatisch schlechtere Bewertungen gibt, weil in den Trainingsdaten solche Gebiete häufiger mit Kreditausfällen verbunden sind, auch wenn eine Einzelperson aus dieser Gegend eigentlich zuverlässig wäre.

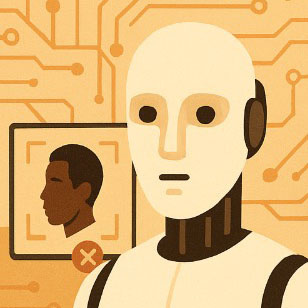

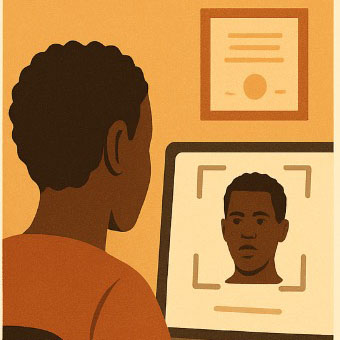

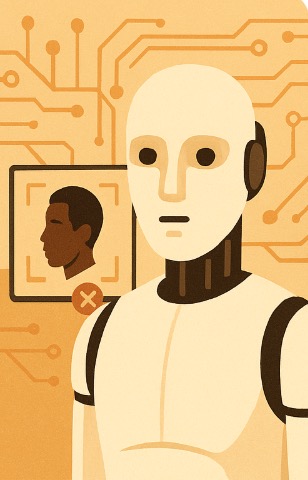

Racial Bias (rassistische Verzerrung) ist eine spezielle Form des algorithmischen Bias, die sich explizit auf Vorurteile gegenüber ethnischen Gruppen oder Hautfarben bezieht. Diese Verzerrung entsteht häufig, weil die Trainingsdaten hauptsächlich weisse Personen enthalten und andere ethnische Gruppen unterrepräsentiert sind. Praxisbeispiele für Racial Bias sind z. B. Gesichtserkennungssysteme, die weisse Gesichter sehr präzise erkennen, aber mehr Fehler bei schwarzen oder asiatischen Gesichtern machen; Sprachmodelle, die rassistische Stereotypen übernehmen; oder Polizeialgorithmen, die aufgrund vorhandener Polizeistatistiken Stadtviertel mit einem hohen Anteil an People of Color häufiger als «gefährlich» einstufen.

Die Folgen solcher Verzerrungen sind weitreichend und führen zu ungerechter Behandlung von Menschen, etwa durch geringere Jobchancen, schlechtere Kreditkonditionen oder stärkere Überwachung. Da KI-Systeme oft als objektiv wahrgenommen werden, können diese Vorurteile unbemerkt bleiben und sich sogar verstärken.

Perspektiven im Überblick

Gesellschaftlich-

kulturelle Perspektive

Diese Perspektive ergründet, wie sich racial und algorithmischer Bias auf die Lebenswelt auswirken.

Anwendungs-

bezogene Perspektive

Diese Perspektive zeigt auf, wie und wo Informatiksysteme genutzt werden und wie diese zu racial oder algorithmischem Bias führen.

WarmUp

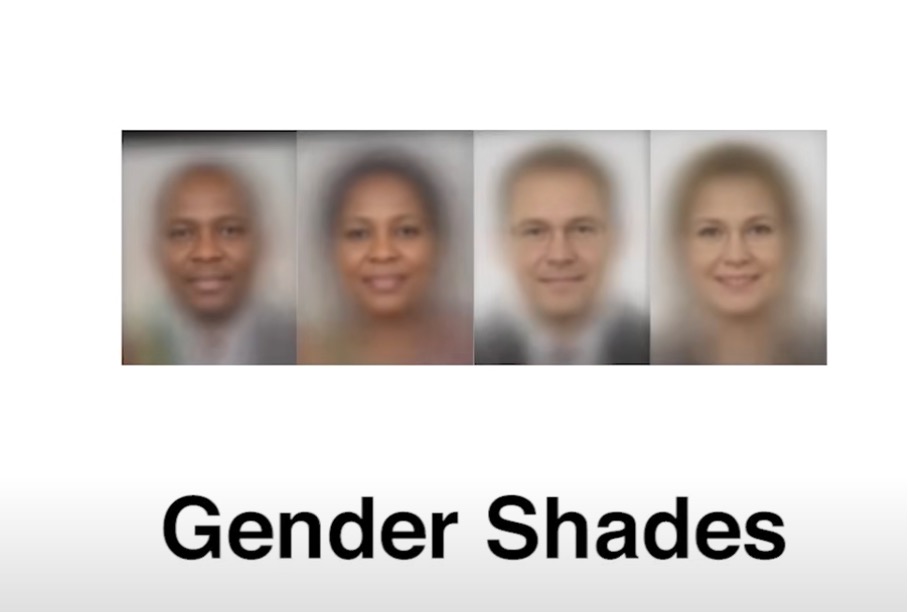

Schaue dir das Video «Gender Shades» an.

Beantworte anschliessend folgende Fragen:

- Warum erkennen manche Gesichtserkennungssysteme dunklere Haut seltener korrekt?

- Welche Rolle spielt die Zusammensetzung der Trainingsdaten?

- Wie könnten historische oder gesellschaftliche Ungleichheiten in technische Systeme hineingelangen?

Technologische

Perspektive

Die technologische Perspektive analysiert die inneren Mechanismen der Systeme. Bias entsteht auf der Ebene der Datenerhebung, -aufbereitung und -verteilung durch die Wahl der Algorithmen sowie durch Optimierungsziele (z. B. Genauigkeit vs. Fairness). Maschinelles Lernen operiert nach dem Prinzip der Mustererkennung: Werden bestimmte Gruppen in den Trainingsdaten unterrepräsentiert, so führt dies zwangsläufig zu schlechterer Modellleistung für diese Gruppen. Auch implizite Annahmen im Feature Engineering oder in der Gewichtung von Variablen können diskriminierende Effekte erzeugen. Die technologische Perspektive bietet das Instrumentarium, diese Mechanismen sichtbar zu machen und technische Gegenmassnahmen (Fairness-Metriken, diversere Trainingsdaten, Bias-Mitigation-Algorithmen) zu entwickeln.

Quelle: KI-generiertes Bild, erstellt mit OpenAI / ChatGPT (DALL·E), am 02.09.2025.

Zentrale Idee: Wie entsteht Bias auf Daten- und Systemebene?

Mögliche Fragen im Unterricht:

- Wie könnten Informatikerinnen und Informatiker prüfen, ob ihr System fair ist?

- Was bedeutet: „Ein Algorithmus lernt aus Daten“?

- Wie kann es passieren, dass Daten verzerrt oder unausgewogen sind?

- Warum führen ungleiche Daten zu ungleichen Ergebnissen?

- Welche Möglichkeiten gibt es, Bias technisch zu reduzieren (z. B. diversere Datensätze, Fairness-Algorithmen)?

Gesellschaftlich-kulturelle Perspektive

Aus der gesellschaftlich-kulturellen Perspektive wird deutlich, dass algorithmischer Bias nicht im Vakuum entsteht, sondern auf gesellschaftlich vorgeprägten Macht- und Ungleichheitsstrukturen basiert. Trainingsdaten sind nicht neutral, sondern Ausdruck sozialer Praktiken und historischer Diskriminierung. So werden stereotype Rollenbilder (z. B. „Führungskräfte sind männlich“) oder ungleiche Chancenverteilungen (z. B. bestimmte Gruppen erhalten seltener Kredite) in den Daten abgebildet und anschliessend algorithmisch verstärkt. Diese Perspektive fragt nach den normativen Implikationen: Welche Werte, Interessen und Vorurteile werden durch Technik reproduziert oder sogar zementiert? Damit rücken ethische Grundsätze wie Fairness, Transparenz und Teilhabe ins Zentrum.

Quelle: KI-generiertes Bild, erstellt mit OpenAI / ChatGPT (DALL·E), am 02.09.2025.

Zentrale Idee: Wie beeinflusst Bias Gesellschaft, Kultur und Werte?

Mögliche Fragen im Unterricht:

- Welche Formen von Diskriminierung gibt es in unserer Gesellschaft und wie können sie in Daten auftauchen?

- Ist Technik „neutral“ oder übernimmt sie menschliche Vorurteile?

- Welche Gruppen sind von algorithmischem Bias besonders betroffen (z. B. Geschlecht, Alter, Herkunft, Behinderung)?

- Welche ethischen Prinzipien (Fairness, Gerechtigkeit, Transparenz) sind wichtig, wenn Algorithmen Entscheidungen treffen?

- Wer trägt die Verantwortung, wenn ein Algorithmus diskriminiert: die Entwicklerinnen, die Nutzerinnen oder „die Technik“?

Anwendungsbezogene Perspektive

Die anwendungsbezogene Perspektive richtet den Blick darauf, wie Systeme konkret in Organisationen, Institutionen oder Alltagskontexte eingebettet werden. Bias wird hier nicht nur als technisches Fehlverhalten sichtbar, sondern als Faktor, der reale Handlungs- und Entscheidungsspielräume beeinflusst. Beispiele sind automatisierte Bewerbungsfilter, die Frauen oder ältere Menschen systematisch benachteiligen, oder Kredit-Scoring-Systeme, die Menschen aus bestimmten Wohngegenden schlechter bewerten. In dieser Perspektive wird untersucht, wie Einsatzkontexte, Nutzerinteressen und organisatorische Rahmenbedingungen Bias verstärken oder abschwächen können. Damit wird klar, dass die Folgen algorithmischer Verzerrungen nicht allein aus den Daten resultieren, sondern wesentlich durch die Art und Weise ihrer Anwendung bestimmt sind.

Zentrale Idee: Wie wirkt Bias in konkreten Nutzungssituationen?

Mögliche Fragen im Unterricht:

- In welchen Bereichen unseres Alltags werden Algorithmen eingesetzt (Bewerbungen, Polizei, Social Media, Kreditvergabe, Werbung)?

- Welche Chancen bringt der Einsatz solcher Systeme (z. B. Zeitersparnis, Effizienz)?

- Welche Risiken entstehen, wenn die Systeme unfair sind?

- Wie würden wir uns fühlen, wenn wir durch ein automatisches System benachteiligt würden?

- Sollten bestimmte Anwendungen (z. B. Gesichtserkennung in der Öffentlichkeit) reguliert oder verboten werden?

Gesamtblick

Ein Gesamtblick auf algorithmischen und racial Bias zeigt, dass das Phänomen nur verstanden werden kann, wenn man alle drei Perspektiven zusammendenkt. Aus gesellschaftlich-kultureller Sicht wird deutlich, dass Algorithmen nicht im luftleeren Raum entstehen, sondern gesellschaftliche Vorurteile und historische Diskriminierungen widerspiegeln. Die anwendungsbezogene Perspektive verdeutlicht, dass Bias immer in konkreten Kontexten wirksam wird – etwa bei Bewerbungen, in der Polizei oder in sozialen Medien – und dort reale Auswirkungen auf Chancen und Teilhabe von Menschen hat. Aus der technologischen Perspektive schliesslich lässt sich erklären, wie Verzerrungen durch unausgewogene Daten oder algorithmische Entscheidungen entstehen und wie sie technisch erkannt oder reduziert werden können. Erst das Zusammenspiel aller drei Sichtweisen erlaubt ein umfassendes Verständnis: Bias ist nicht nur ein Problem der Technik, sondern auch der Anwendung und der Gesellschaft – und nur durch diesen Gesamtblick lassen sich Wege zu gerechteren und inklusiveren digitalen Systemen entwickeln.

BY Konsortium MIA21

Dieser Beitrag ist lizenziert unter der Creative Commons Namensnennung 4.0 International Lizenz (CC BY 4.0).

Praxis und Unterricht

Dagstuhl-Dreieck

Wir leben in einer digital geprägten Gesellschaft, in der Kultur der Digitalität (Stalder), was Veränderungen in der Lebens- und Arbeitswelt …

Hello Ruby – Programmier dir deine Welt

Thema: Computational Thinking (Grundkonzepte des Programmierens)

Herausgeber: Bananenblau

Stufe: Zyklus 1

Das Buch von Linda Liukas führt auf spielerische und …

Informatik Biber:

Ausgewählte Graph Biber Karten

Thema: Algorithmen, Graphen

Herausgeber: Informatik Biber Schweiz

Stufe: Zyklus 2

Die Informatik Biber Materialien stehen jeweils thematisch zur Verfügung und …

Bilderbuch zu Künstlicher Intelligenz

Thema: Maschinelles Lernen und künstliche Intelligenz

Herausgeber: Bananenblau

Stufe: Zyklus 1

Das Buch von Linda Liukas führt Kinder in das …

SoekiaGPT

Thema: Sprachmodelle und künstliche Intelligenz

Herausgeber: Michael Hielscher und Werner Hartmann

Stufe: Zyklus 3

SoekiaGPT ist ein leistungsstarkes und vielseitiges …

Weiterführende Phänomene und Konzepte

Over-Tourism durch soziale Medien

Soziale Medien verwandeln versteckte Geheimtipps in überlaufene Hotspots. Virale Posts bekannter Influencer*innen können dazu führen, dass nicht nur bekannte Tourismusorte …

Wikipedia – Anatomie eines fragilen Phänomens

Ob zur Unterrichtsvorbereitung, bei Rechercheaufgaben oder zur schnellen Klärung von Fakten bei Uneinigkeiten – Wikipedia hat sich als fester Bestandteil …

TikTok – Mehr als nur Tanz und Trends

Auf TikTok wird getanzt, gesprochen, gelacht – und manchmal auch diskutiert. Die App ist für viele Jugendliche längst mehr als …

Maschinengenerierte Schönheitsideale

Digitale Medien können ein Mittel zur Selbstinszenierung sein. Filter, Selfies, Avatare und Profilbilder beeinflussen, wie Kinder und Jugendliche sich selbst …

Digital Health

Wearables, also tragbare Technologien wie Fitness-Tracker oder Smartwatches, erlauben es uns, unsere Gesundheit, Fitness oder unseren Schlaf kontinuierlich zu überwachen …

Online-Bewerbungen

Online-Bewerbungen bieten eine Reihe von Vorteilen im Vergleich zu traditionellen Bewerbungsverfahren auf Papier. Bewerbungen sind von überall aus möglich, die …